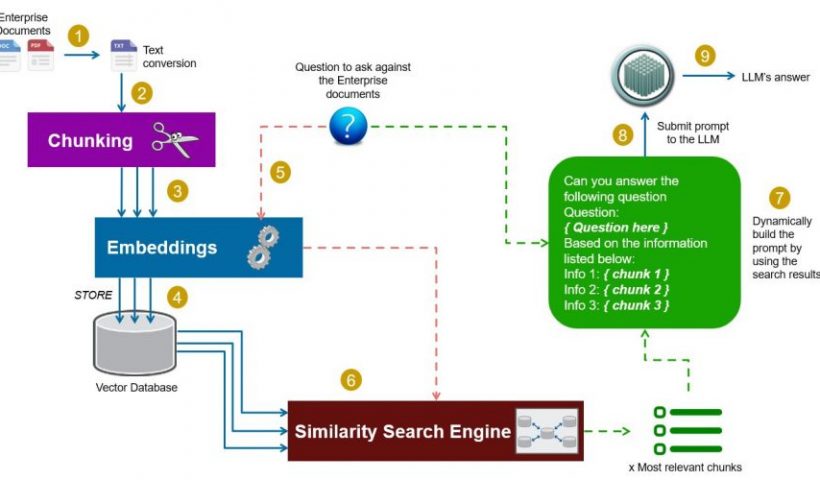

Suite à l’un de mes précédent article sur le RAG (Retrieval Augmented Generation), et quelques commentaires pertinents de lecteurs, je me dois d’aller plus dans le détail sur cette technologie. En fait je vais faire mieux que cela, et je vais décomposer pierre par pierre cette technique et vous montrer qu’elle n’est pas très complexe finalement.

Commençons par un article explicatif, et les prochain seront eux focalisés sur la mise en oeuvre étape par étape.

Catégorie : Intelligence Artificielle

L’Intelligence Artificielle est au coeur de nos vies et de nos usages. Dans ces articles nous verrons comment cette fameuse IA fonctionne, quels sont ses mécanismes et ce que l’on peut en faire.

Document chunking !

Le document chunking est une pratique courante en intelligence artificielle qui prend de plus en plus d’importance avec la démocratisation des LLM et dutraitements de données textuelles via NLP en général. Son objectif est de permettre le découpage de vastes ensembles de documents en segments plus petits. Cette méthode ou technique facilite grandement l’analyse et le traitement des informations permettant aux algorithmes d’IA d’opérer de manière plus efficiente sur des portions de texte réduites. L’objectif est de réduire la surcharge d’informations et les problèmes de performance liés au traitement de documents entiers. De plus, cette segmentation permet de réduire la complexité des tâches d’analyse, en offrant une approche plus gérable pour les modèles d’IA.

Document chunking !Utiliser (facebook) BART pour faire un résumé (4 méthodes !)

Dans cet article nous allons voir de 4 manière différente comment utiliser le LLM BART pour résumer un texte.

Utiliser (facebook) BART pour faire un résumé (4 méthodes !)Premiers pas vers un RAG en augmentant un LLM avec un fichier pdf (en 5 mins chrono)

Les LLMs ne sont entrainés qu’avec des données dites « génériques » ce qui ne répond pas toujours à nos attentes. Dans cet article nous allons voir comment influencer la réponse de notre LLM à partir de données provenant d’un simple fichier pdf.

Premiers pas vers un RAG en augmentant un LLM avec un fichier pdf (en 5 mins chrono)